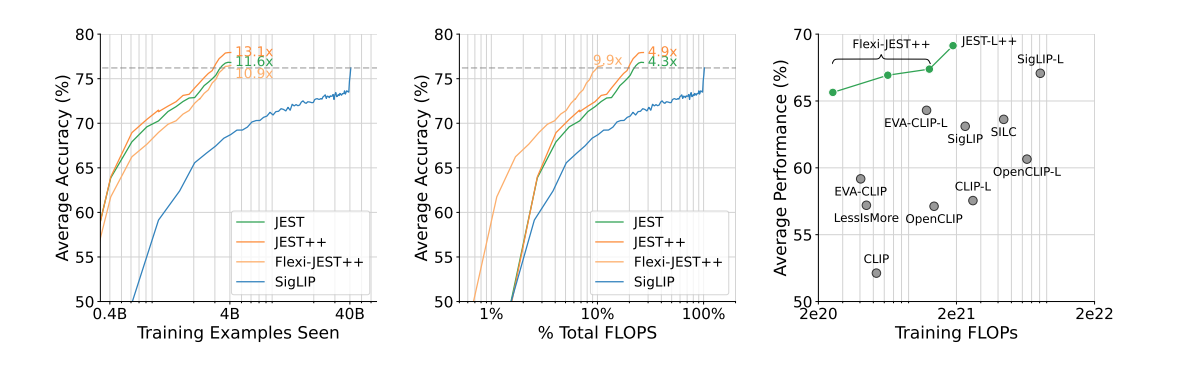

O Google DeepMind, laboratório de pesquisa de IA do Google, publicou uma novidade pesquisa sobre treinamento de modelos de IA que alega açodar muito a velocidade de treinamento e a eficiência energética em uma ordem de magnitude, gerando 13 vezes mais desempenho e dez vezes mais eficiência energética do que outros métodos. O novo método de treinamento JEST chega em um momento oportuno, pois as conversas sobre o impacto ambiental dos data centers de IA estão esquentando.

O método da DeepMind, chamado JEST ou seleção conjunta de exemplos, rompe com as técnicas tradicionais de treinamento de modelos de IA de forma simples. Os métodos de treinamento típicos focam em pontos de dados individuais para treinamento e tirocínio, enquanto o JEST treina com base em lotes inteiros. O método JEST primeiro cria um protótipo de IA menor que classificará a qualidade dos dados de fontes de qualidade extremamente subida, classificando os lotes por qualidade. Em seguida, ele compara essa classificação a um conjunto maior e de qualidade subordinado. O pequeno protótipo JEST determina os lotes mais adequados para treinamento, e um protótipo grande é portanto treinado a partir das descobertas do protótipo menor.

O cláusula em si, disponível cá, fornece uma explicação mais completa dos processos usados no estudo e do porvir da pesquisa.

Os pesquisadores da DeepMind deixam evidente em seu cláusula que essa “habilidade de direcionar o processo de seleção de dados para a distribuição de conjuntos de dados menores e muito curados” é principal para o sucesso do método JEST. Sucesso é a termo correta para essa pesquisa; a DeepMind afirma que “nossa abordagem supera modelos de última geração com até 13× menos iterações e 10× menos computação”.

🔥 Dica do Técnico: Encontra gadgets e peças de reparação a preços incríveis.

Ver Ofertas Flash ⚡*Ao comprar através deste link, apoias o site sem custo extra.

Evidente, esse sistema depende inteiramente da qualidade de seus dados de treinamento, pois a técnica de bootstrapping desmorona sem um conjunto de dados com curadoria humana da mais subida qualidade verosímil. Em nenhum lugar o mantra “lixo entra, lixo sai” é mais verdadeiro do que neste método, que tenta “pular para frente” em seu processo de treinamento. Isso torna o método JEST muito mais difícil para amadores ou desenvolvedores de IA amadores igualarem do que a maioria dos outros, pois habilidades de pesquisa de nível especializado provavelmente são necessárias para remediar os dados de treinamento iniciais de mais cocuruto proporção.

A pesquisa do JEST não chega nem um momento antes, já que a indústria de tecnologia e os governos mundiais estão começando discussões sobre as demandas extremas de virilidade da lucidez sintético. As cargas de trabalho de IA ocuparam murado de 4,3 GW em 2023, quase igualando o consumo anual de virilidade da região de Chipre. E as coisas definitivamente não estão desacelerando: uma única solicitação do ChatGPT custa 10x mais do que uma pesquisa do Google em virilidade, e o CEO da Arm estima que a IA ocupará um quarto da rede elétrica dos Estados Unidos até 2030.

Se e porquê os métodos JEST serão adotados pelos principais participantes do espaço da IA ainda está para ser visto. O GPT-4o supostamente custou US$ 100 milhões para treinar, e futuros modelos maiores podem em breve atingir a marca de um bilhão de dólares, portanto as empresas provavelmente estão procurando maneiras de forrar suas carteiras neste departamento. Os esperançosos acham que os métodos JEST serão usados para manter as taxas atuais de produtividade de treinamento em consumos de virilidade muito menores, aliviando os custos da IA e ajudando o planeta. No entanto, é muito mais provável que a máquina do capital mantenha o pedal no metal, usando métodos JEST para manter o consumo de virilidade no supremo para saída de treinamento hiper-rápida. Economia de custos versus graduação de produção, quem vencerá?